智能计算的基石 服务器软硬件架构与基础软件服务深度解析

在人工智能与大数据浪潮的推动下,智能计算已成为驱动社会数字化转型的核心引擎。其效能与稳定性的根基,深植于精心设计的服务器软硬件架构以及承载其上的基础软件服务。本文将系统性地剖析这两大基石,揭示它们如何共同构建起现代智能计算的高效、可靠运行环境。

一、服务器硬件架构:算力的物理承载

智能计算对算力的渴求是近乎无限的,这直接驱动了服务器硬件架构的持续演进。其核心组件构成了一个高效协同的计算体系:

- 计算核心(CPU/GPU/XPU):中央处理器(CPU)作为通用控制与调度中心,负责复杂逻辑与任务协调。而在智能计算场景中,图形处理器(GPU)因其大规模并行计算能力,已成为训练深度学习模型的主力。为特定场景优化的专用处理器(如TPU、NPU等XPU)也在崛起,提供更高的能效比。

- 内存与存储层次:海量数据的快速存取离不开分层存储架构。高速缓存(Cache)、大容量内存(DRAM)确保了计算核心的“粮草”供应;而NVMe SSD等高性能固态硬盘,以及分布式存储系统,则构成了庞大的数据仓库,满足模型参数和训练数据集的高吞吐、低延迟访问需求。

- 高速互联网络:在分布式计算集群中,服务器节点间的通信效率至关重要。InfiniBand、RoCE等高速网络技术,以及NVLink等GPU间直连技术,极大降低了数据交换与同步的延迟,使得千卡乃至万卡集群能够如同一台巨型计算机般协同工作。

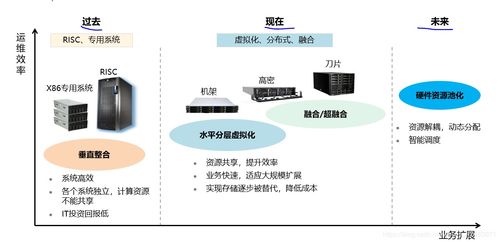

二、服务器软件架构:资源的智慧调度

硬件能力需要通过软件才能被充分释放和灵活组织。服务器软件架构的核心目标在于实现资源的抽象、池化与智能化调度。

- 虚拟化与容器化:虚拟化技术(如KVM、VMware)将物理服务器抽象为多个逻辑独立的虚拟机。而容器技术(以Docker为代表)及其编排系统Kubernetes(K8s),则以更轻量、更敏捷的方式封装应用与依赖,实现了资源的精细化管理和弹性伸缩,成为部署AI微服务的标准范式。

- 资源管理与调度器:YARN、Mesos,以及K8s的调度器,是集群的“大脑”。它们根据任务优先级、资源需求、数据本地性等因素,动态地将计算任务(如Spark作业、AI训练任务)分配给最合适的硬件资源,最大化集群整体利用率。

- 监控与运维体系:完善的监控系统(如Prometheus、Grafana)实时收集硬件健康状态、资源使用率、应用性能指标等数据,结合日志系统(如ELK Stack)和告警机制,为系统的稳定、高效运行提供保障,并辅助进行容量规划与故障预测。

三、基础软件服务:智能应用的生命线

在软硬件架构之上,一系列基础软件服务为智能计算应用提供了不可或缺的通用支撑能力,构成了应用开发的“新基建”。

- 分布式文件与对象存储:如HDFS、Ceph、MinIO等服务,提供了可扩展、高可靠的海量数据存储能力,是训练数据的集中管理池。

- 大数据处理框架:Apache Spark、Flink等框架,提供了强大的离线批处理和实时流数据处理能力,是进行数据清洗、特征工程等预处理环节的关键工具。

- AI开发框架与平台:TensorFlow、PyTorch等深度学习框架极大降低了模型研发门槛。而MLflow、Kubeflow等MLOps平台,则帮助管理模型的全生命周期——从实验跟踪、版本控制到自动化训练、部署与监控。

- 服务网格与API网关:在微服务架构下,Istio等服务网格管理服务间的通信、安全与可观测性;API网关则作为统一的流量入口,处理路由、认证、限流等策略,保障AI服务接口的稳定与安全。

###

智能计算的宏伟大厦,始于服务器硬件的坚实“地基”,成于服务器软件的灵活“框架”,最终通过丰富的基础软件“设施”赋能千行百业。软硬件架构的协同优化与基础服务的持续演进,是释放算力潜能、降低应用成本、加速智能落地的关键。随着存算一体、CXL互联、量子计算等新硬件形态,以及Serverless、AI原生架构等新软件范式的成熟,这一基石将被赋予更强大的智能与更极致的效率,持续推动智能计算迈向新的高度。

如若转载,请注明出处:http://www.jobtankchina.com/product/49.html

更新时间:2026-02-24 07:59:02